Sistemas lineares - Descrição e análise (com rotinas em Python)¶

Seja um sistema linear conforme representado abaixo:

$$ \mathbf{A} \cdot \overrightarrow{x} = \overrightarrow{y} $$Ou em sua forma aberta matricialmente:

$$ \left( \begin{matrix} a_{1,1} & a_{1,2} & ... & a_{1,m} \\ a_{2,1} & a_{2,2} & ... & a_{2,m} \\ ... & ... & ... & ... \\ a_{n,1} & a_{n,2} & ... & a_{n,m} \end{matrix} \right) \cdot \left( \begin{matrix} x_1 \\ x_2 \\ ... \\ x_m \end{matrix} \right) = \left( \begin{matrix} y_1 \\ y_2 \\ ... \\ y_n \end{matrix} \right) $$Ou alternativamente representado como:

$$ \underbrace{ \left( \begin{matrix} a_{1,1} \\ a_{2,1} \\ ... \\ a_{n,1} \end{matrix} \right) }_{ \overrightarrow{a}_1^C } \cdot x_1 + \underbrace{ \left( \begin{matrix} a_{1,2} \\ a_{2,2} \\ ... \\ a_{n,2} \end{matrix} \right) }_{ \overrightarrow{a}_2^C } \cdot x_2 + ... + \underbrace{ \left( \begin{matrix} a_{1,m} \\ a_{2,m} \\ ... \\ a_{n,m} \end{matrix} \right) }_{ \overrightarrow{a}_m^C } \cdot x_m = \underbrace{ \left( \begin{matrix} y_1 \\ y_2 \\ ... \\ y_n \end{matrix} \right) }_{ \overrightarrow{y} } $$Ou seja:

$$ \overrightarrow{a}_1^C \cdot x_1 + \overrightarrow{a}_2^C \cdot x_2 + ... + \overrightarrow{a}_m^C \cdot x_m = \overrightarrow{y} $$Logo, da expressão acima, fica evidente que o vetor $ \overrightarrow{y} $ é combinação linear dos vetores coluna da matriz $ \mathbf{A} $. Em termos matemáticos, o conjunto de todos os vetores que resultam da combinação linear dos vetores coluna da matriz é chamado de espaço vetorial coluna dos vetores coluna da matriz, também designado span.

A base de um espaço vetorial é definida como um conjunto de vetores LI que formam tal espaço. A dimensão de um espaço vetorial é igual oa número de vetores LI que o definem, ou seja:

Vamos também relembrar o posto de uma matriz. Temos que:

$$ \rm{nº \ de \ colunas \ LI \ da \ matriz} \ \mathbf{A} = \rm{nº \ de \ linhas \ LI \ da \ matriz} \ \mathbf{A} = \rm{posto \ da \ matriz} \ \mathbf{A} = p $$Isto significa que o número de linhas e colunas LI da matriz $\mathbf{A}$ é o mesmo, definindo espaços vetoriais $ \mathbf{R}^p $, de dimensão $ p $. O valor de $ p $ é obrigatoriamente menor ou igual à menor dimensão da matriz, ou seja:

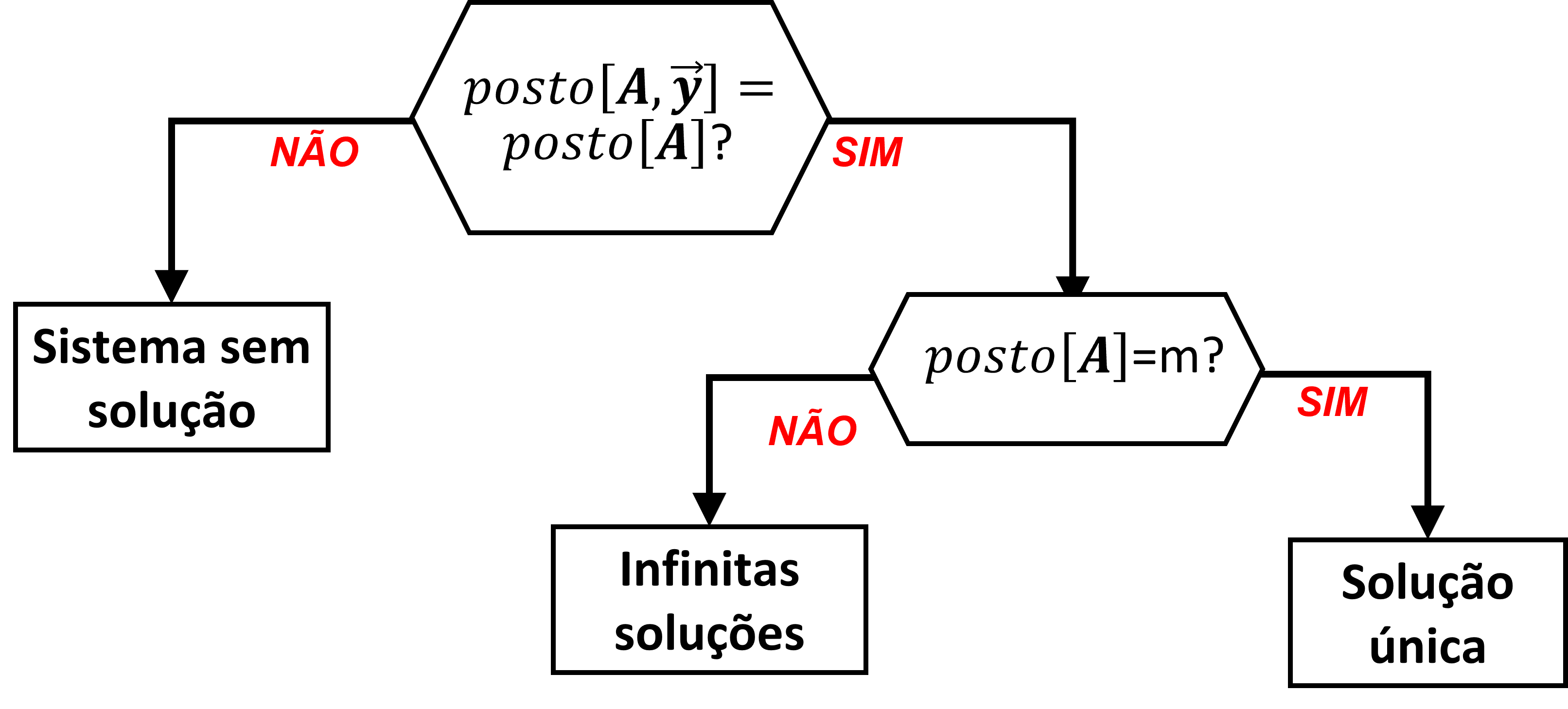

$$ n = \rm{nº \ de \ linhas \ da \ matriz } $$$$ m = \rm{nº \ de \ colunas \ da \ matriz } $$$$ p \leq menor \left( n,m \right) $$A primeira análise dos sistemas lineares do tipo envolve a natureza do problema, como:

- com solução única => resolva

- com infinitas soluções => analise

- sem solução => se for o caso, encontre a solução mais próxima

No Python, o posto de uma matriz pode ser obtido com diversos pacotes. Um dos mais usuais uma rotina do pacote numpy que pode ser acessada com o comando np.linalg.matrix_rank() (onde np é a referência clássica à importação do pacote numpy)

Solução única

O problema terá solução única se:

- o posto da matriz $ \mathbf{A} $ for igual ao número de colunas dela, i.e: $ p = m $ (ou seja, não há colunas linearmente dependente na matriz $ \mathbf{A} $), e

- o vetor $ \overrightarrow{y} $ pertencer ao espaço vetorial formado pelos vetores coluna da matriz $ \mathbf{A} $. Esta condição é garantida se o posto da matriz estendida $ \left[ \mathbf{A}, \overrightarrow{y} \right] $ for igual ao posto da matriz $ \mathbf{A} $, ou seja: $ posto \left( \left[ \mathbf{A}, \overrightarrow{y} \right] \right) = posto \left( \mathbf{A} \right) $

Infinitas soluções

O problema terá infinitas soluções se:

- o posto da matriz $ \mathbf{A} $ for menor que número de colunas dela, i.e: $ p < m $ (ou seja, HÁ colunas linearmente dependente na matriz $ \mathbf{A} $), e

- o vetor $ \overrightarrow{y} $ pertencer ao espaço vetorial formado pelos vetores coluna da matriz $ \mathbf{A} $. Esta condição é garantida se o posto da matriz estendida $ \left[ \mathbf{A}, \overrightarrow{y} \right] $ for igual ao posto da matriz $ \mathbf{A} $, ou seja: $ posto \left( \left[ \mathbf{A}, \overrightarrow{y} \right] \right) = posto \left( \mathbf{A} \right) $

Sem solução

O problema naõ terá solução se:

- o vetor $ \overrightarrow{y} $ NÃO pertencer ao espaço vetorial formado pelos vetores coluna da matriz $ \mathbf{A} $. Esta condição é garantida se o posto da matriz estendida $ \left[ \mathbf{A}, \overrightarrow{y} \right] $ for igual ao posto da matriz $ \mathbf{A} $, ou seja: $ posto \left( \left[ \mathbf{A}, \overrightarrow{y} \right] \right) > posto \left( \mathbf{A} \right) $

A figura a seguir ilustra a análise do sistema linear:

No Python, esta análise pode ser feita conforme código a seguir: